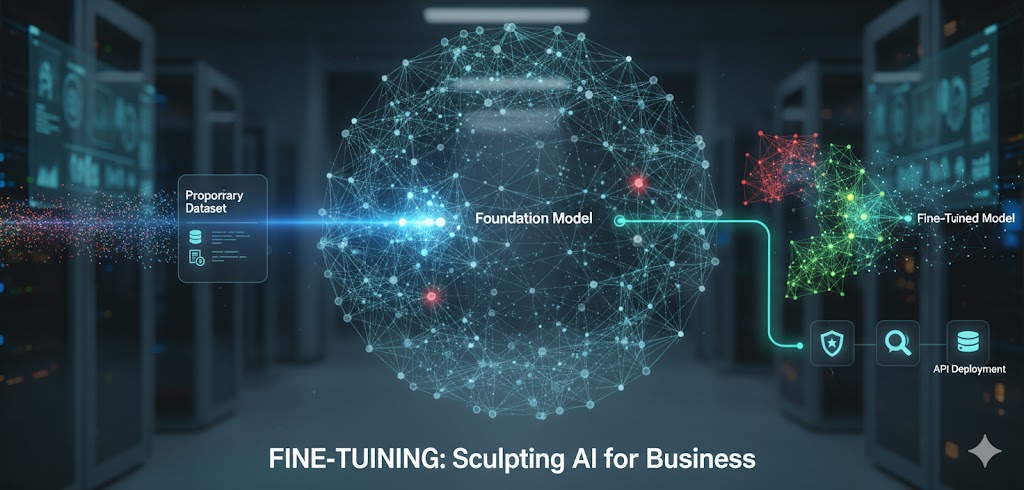

Dans la course à l’innovation, l’utilisation de modèles d’intelligence artificielle générique ne constitue plus un avantage concurrentiel suffisant. Pour qu’une IA devienne un véritable levier de croissance, elle doit parler la langue de l’entreprise, comprendre ses codes internes et répondre avec une précision chirurgicale à ses problématiques spécifiques. C’est ici qu’intervient le Fine-Tuning (ou ajustement fin), une technique de pointe consistant à spécialiser un modèle de fondation pré-entraîné sur un jeu de données restreint et ciblé.

Contrairement au « Prompt Engineering » qui se contente de donner des instructions contextuelles, le fine-tuning modifie les poids internes du réseau de neurones pour ancrer de nouveaux comportements. Pour un décideur business, c’est le passage d’une IA « encyclopédique » à une IA « experte métier ».

Pourquoi le Fine-Tuning est devenu indispensable en entreprise

Le déploiement de modèles massifs comme Gemini ou GPT-4 offre des capacités impressionnantes, mais ils souffrent souvent d’un manque de spécialisation. Le fine-tuning permet de combler ce fossé technique. Le premier bénéfice est la maîtrise du ton et du style. Une banque d’investissement n’utilise pas le même registre sémantique qu’une start-up de jeux vidéo ; l’ajustement fin permet d’uniformiser la voix de l’IA sur l’ensemble des points de contact clients.

Ensuite, cette méthode réduit drastiquement les hallucinations. En exposant le modèle à des exemples de réponses correctes et validées par des experts humains, on réduit la probabilité que l’IA invente des faits. Enfin, l’aspect économique est non négligeable. Un modèle plus petit, finement ajusté (comme un modèle de 7 milliards de paramètres), peut surpasser un modèle géant sur une tâche précise, tout en étant beaucoup plus rapide et moins coûteux à faire fonctionner en production.

La préparation des données : Le socle de la performance

Le succès d’une opération de fine-tuning repose à 80% sur la qualité des données fournies. Il ne s’agit pas de quantité, mais de pertinence. Pour ajuster un modèle, les entreprises utilisent généralement des fichiers au format JSONL, structurés sous forme de paires « Instruction/Réponse » ou « Prompt/Cible ».

La phase de préparation implique un nettoyage rigoureux :

- Suppression des doublons : Pour éviter que le modèle ne sur-apprenne (overfitting) des exemples spécifiques.

- Diversification des exemples : Pour que l’IA conserve une capacité d’adaptation face à des requêtes variées.

- Anonymisation : Il est impératif de retirer toute donnée à caractère personnel (DCP) avant d’injecter les données dans le pipeline d’entraînement, afin de respecter les normes de conformité comme le RGPD.

Un jeu de données de quelques centaines d’exemples de haute qualité suffit souvent à transformer radicalement les performances d’un modèle sur une tâche de classification, d’extraction d’entités ou de résumé spécialisé.

Les différentes méthodes techniques d’ajustement

Il existe plusieurs approches pour réaliser un fine-tuning, chacune ayant un impact différent sur les ressources de calcul. Le Fine-Tuning Complet consiste à mettre à jour tous les paramètres du modèle. C’est la méthode la plus puissante, mais aussi la plus gourmande en processeurs graphiques (GPU).

Aujourd’hui, les entreprises privilégient souvent le PEFT (Parameter-Efficient Fine-Tuning), et plus particulièrement la technique LoRA (Low-Rank Adaptation). Au lieu de modifier les milliards de paramètres du modèle original, LoRA ajoute de petites couches de paramètres supplémentaires qui sont les seules à être entraînées. Cela permet d’obtenir des résultats quasi identiques au fine-tuning complet tout en divisant par dix ou cent les besoins en mémoire et en stockage. Cette efficacité permet même de changer de « personnalité » d’IA à la volée en changeant simplement ces petites couches de paramètres (appelées adaptateurs) sur un modèle de base unique.

Évaluation et déploiement du modèle spécialisé

Une fois la phase d’entraînement terminée dans un environnement comme Vertex AI ou une infrastructure dédiée, l’étape cruciale est l’évaluation. On utilise pour cela un jeu de données de test que l’IA n’a jamais vu. Les ingénieurs analysent des métriques telles que la « Perplexity » (la confiance du modèle dans ses prédictions) ou font appel à des évaluations humaines pour comparer les réponses du modèle ajusté par rapport au modèle de base.

Le déploiement intervient une fois que le gain de performance est validé. Le modèle spécialisé est alors exposé via une API. Dans un contexte de production, il est fréquent de mettre en place des tests A/B : une partie du trafic est envoyée vers l’IA générique et l’autre vers l’IA ajustée pour mesurer l’impact réel sur les indicateurs de performance (KPI) de l’entreprise, comme le taux de satisfaction client ou le temps de résolution des requêtes.

Sécurité, éthique et confidentialité des modèles personnalisés

L’un des principaux freins au fine-tuning est la crainte de la fuite de propriété intellectuelle. Cependant, les plateformes de Cloud professionnelles garantissent aujourd’hui que les données utilisées pour l’ajustement fin restent cloisonnées au sein du projet de l’entreprise. Le modèle ainsi créé appartient à l’organisation et n’est jamais partagé avec d’autres clients ou utilisé par le fournisseur pour améliorer ses propres services publics.

Sur le plan éthique, le fine-tuning permet de renforcer les garde-fous. En entraînant spécifiquement l’IA à refuser de répondre à certaines catégories de questions sensibles ou à éviter les biais discriminatoires propres à son domaine d’activité, les entreprises sécurisent leur déploiement. C’est une étape de contrôle indispensable pour transformer une technologie expérimentale en un outil professionnel fiable et responsable.